#disinfo

2020-04-01

wenyi

02:14:13

補充一下後來我是直接用python的 set 找差集,比較方便,不用用到sql的join。政黑版少了40篇已經補完(用之前寫的 `article.py discover`,直接給url就可以加入db了),但八卦版少 443k (2019 + 2020) 篇… 好消息是2019年10, 11, 12 月 和 2020 年1, 2月 都已經蒐集完

ronnywang

11:46:18

HTML 真的很肥大

ronnywang

11:46:47

不過 snapshot 是全部版本都會留嗎?無論文章內容有沒有變?

ronnywang

11:47:16

newsdiff 的作法是新的 snapshot 進來先直接 parse 出 title, body 。如果 title/body 都跟前版沒變的話,那這個新的 snapshot 就不存下來了

ronnywang

11:48:09

這樣優點比較省空間,畢竟不是每篇文章都那麼常變動。缺點是假如他網站架構變了就會有一段時間的 snapshot 存不到了

ronnywang

11:48:49

而且 parse 和 crawl 要同時做,不能分開成兩隻程式

pm5

12:10:43

目前要 parse 出來的資訊欄位還在增加中,所以一時還無法刪掉舊的 snapshot

pm5

12:12:53

也是可以考慮只看 title and body 決定要不要留 snapshot,因為還在增加的要 parse 的欄位看起來都是 metadata,這個通常在同一篇文章裡不會變

ronnywang

13:03:41

目前一篇 article 會留 7 個 articlesnapshot 版本嗎

pm5

13:16:37

是的

pm5

13:18:46

我也要想一下我們現在 parse 跟 crawl 分開做的情況下,要怎麼看 title and body 有沒有變

ronnywang

13:19:21

把 parse 後發現沒變的結果再刪掉

pm5

13:23:45

@chihao @ayw255 2 月份的 data loss 事件,調查結果是系統自己可以回復的都回復了,剩下無法回復的都是已經 404 的文章 https://github.com/disinfoRG/ZeroScraper/issues/94#issuecomment-607024008

GitHub

The main reasons that we want to recover article snapshot data are: Some snapshots are not parsed yet before the data loss incident. Some snapshots are parsed before the incident and were saved in ...

- 👍2

chihao

14:32:03

我覺得資料備份機制可能需要儘快處理 😛 要來特別揪一個討論嗎?

mrorz

2020-04-01 14:35:13

Cofacts 的 elasticsearch (6.3) 是是弄個 bash script:

```#!/bin/bash

SNAPSHOT_NAME=`date --iso-8601`

cd ~docker/rumors-deploy

/usr/local/bin/docker-compose exec -T db curl -XPUT localhost:9200/_snapshot/gcs/$SNAPSHOT_NAME```

然後放進 crontab 每週日凌晨執行。

Elasticsearch snapshot 是 incremental snapshot,備份時 DB 也不用關掉,我覺得很方便。

備份方面 `gcs` repo 用的是這個:https://www.elastic.co/guide/en/elasticsearch/plugins/master/repository-gcs.html

Elasticsearch (7.6) snapshot doc: https://www.elastic.co/guide/en/elasticsearch/reference/current/snapshots-take-snapshot.html

```#!/bin/bash

SNAPSHOT_NAME=`date --iso-8601`

cd ~docker/rumors-deploy

/usr/local/bin/docker-compose exec -T db curl -XPUT localhost:9200/_snapshot/gcs/$SNAPSHOT_NAME```

然後放進 crontab 每週日凌晨執行。

Elasticsearch snapshot 是 incremental snapshot,備份時 DB 也不用關掉,我覺得很方便。

備份方面 `gcs` repo 用的是這個:https://www.elastic.co/guide/en/elasticsearch/plugins/master/repository-gcs.html

Elasticsearch (7.6) snapshot doc: https://www.elastic.co/guide/en/elasticsearch/reference/current/snapshots-take-snapshot.html

揪

mrorz

14:35:13

Cofacts 的 elasticsearch (6.3) 是是弄個 bash script:

```#!/bin/bash

SNAPSHOT_NAME=`date --iso-8601`

cd ~docker/rumors-deploy

/usr/local/bin/docker-compose exec -T db curl -XPUT localhost:9200/_snapshot/gcs/$SNAPSHOT_NAME```

然後放進 crontab 每週日凌晨執行。

Elasticsearch snapshot 是 incremental snapshot,備份時 DB 也不用關掉,我覺得很方便。

備份方面 `gcs` repo 用的是這個:https://www.elastic.co/guide/en/elasticsearch/plugins/master/repository-gcs.html

Elasticsearch (7.6) snapshot doc: https://www.elastic.co/guide/en/elasticsearch/reference/current/snapshots-take-snapshot.html

```#!/bin/bash

SNAPSHOT_NAME=`date --iso-8601`

cd ~docker/rumors-deploy

/usr/local/bin/docker-compose exec -T db curl -XPUT localhost:9200/_snapshot/gcs/$SNAPSHOT_NAME```

然後放進 crontab 每週日凌晨執行。

Elasticsearch snapshot 是 incremental snapshot,備份時 DB 也不用關掉,我覺得很方便。

備份方面 `gcs` repo 用的是這個:https://www.elastic.co/guide/en/elasticsearch/plugins/master/repository-gcs.html

Elasticsearch (7.6) snapshot doc: https://www.elastic.co/guide/en/elasticsearch/reference/current/snapshots-take-snapshot.html

pm5

14:44:31

揪

ronnywang

16:15:20

我又收到硬碟 >80% 的警告信了 XD

ronnywang

16:20:16

在備份之前可以能要解決硬碟要爆的問題 XD

pm5

16:23:11

ArticleSnapshot202002 可以先 archive 起來

pm5

16:24:18

這個我們可以怎麼進行比較方便?

ronnywang

16:26:21

兩個問題

一個是要 archive 在哪裡(現在 ArticleSnapshot202002 是 compressed 而且 40G ,表示要 archive 也要找有 40G 硬碟空間的地方,所以要放哪

另一個是要 archive 成什麼型式,是用 SQL dump 還是 jsonline 還是 csv (我個人比較喜歡 jsonline XD)

一個是要 archive 在哪裡(現在 ArticleSnapshot202002 是 compressed 而且 40G ,表示要 archive 也要找有 40G 硬碟空間的地方,所以要放哪

另一個是要 archive 成什麼型式,是用 SQL dump 還是 jsonline 還是 csv (我個人比較喜歡 jsonline XD)

poga

16:29:01

丟到 s3 或是 b2 blaze?

poga

16:32:49

如果需要機器/storage 的話我應該能問問看 sponsorship... 😛

ronnywang

16:39:44

另外 0archive 的主機原生的 160G 硬碟也只剩下 40G 左右,不確定會不會塞爆。但原生硬碟裡面有 30G 是當初從原來 middle2 搬來的 dump 檔,以及 73G 是之前發生誤砍事件之後,ArticleSnapshot 裡面被刪除文章還沒釋放出空間來的備份檔

ronnywang

16:40:13

這兩個如果覺得不需要可以刪除掉,那這樣至少 ArticleSnapshot202002 可以暫時先放在原生硬碟中

pm5

16:52:21

放在哪裡這個禮拜一討論過 linode 或 nas 或 aws glacier,還沒決定。 @poga 可以幫忙問贊助的話,好啊 XD

poga

16:55:34

目前只需要 storage?如果要分享 raw data 的話 ok 嗎?這些資料應該不是開放授權? XD

可能 storage 跟 GCP quota 都有需要。跟贊助單位分享 raw data 嗎?這我們要問一下囉 cc @chihao

chihao

2020-04-01 17:00:27

哪個單位?XD

chihao

2020-04-01 17:00:46

專案其實有預算,我覺得先估計要花多少錢

poga

2020-04-01 17:01:02

因為 AILabs 也有在作新聞分析,所以我想說兩邊直接共享資料應該是最有效益的?

寫爬蟲好麻煩的... XD

寫爬蟲好麻煩的... XD

養爬蟲也是很麻煩…

pm5

16:55:34

Archive 格式的話 jsonlines 比較好,但是這樣會用什麼工具 dump/load?

可能 storage 跟 GCP quota 都有需要。跟贊助單位分享 raw data 嗎?這我們要問一下囉 cc @chihao

chihao

2020-04-01 17:00:27

哪個單位?XD

chihao

2020-04-01 17:00:46

專案其實有預算,我覺得先估計要花多少錢

poga

2020-04-01 17:01:02

因為 AILabs 也有在作新聞分析,所以我想說兩邊直接共享資料應該是最有效益的?

寫爬蟲好麻煩的... XD

寫爬蟲好麻煩的... XD

養爬蟲也是很麻煩…

pm5

16:58:13

可能 storage 跟 GCP quota 都有需要。跟贊助單位分享 raw data 嗎?這我們要問一下囉 cc @chihao

chihao

17:00:27

哪個單位?XD

chihao

17:00:46

專案其實有預算,我覺得先估計要花多少錢

ronnywang

18:00:57

82% 了,大概一兩個小時 1% ?

chihao

18:05:17

要不要先加容量?

ronnywang

18:28:50

我覺得比較治本應該是把 202002 搬出來,然後盡快實作內容沒變就不要 snapshot 和超過兩個月就 archive ,這樣子現在硬碟空間應該很夠

- 👍1

chihao

2020-04-01 19:34:38

這個感覺是個正式提案了呢!

ronnywang

18:30:15

畢竟現在 snapshot 的量是正常的七倍的量

chihao

19:34:38

這個感覺是個正式提案了呢!

chihao

19:47:40

提案內容 - https://g0v.hackmd.io/I8_OwNM5SI2YYfRrdjvUfg 明天有空來聊聊嗎?@pm5 @ronnywang @ayw255

- 👌1

ronnywang

23:20:47

83% 了,所以大概五個小時 1%

2020-04-02

chihao

11:37:35

關於備份機制,要來個 call 嗎?@ayw255 @pm5 @ronnywang

yeah

chihao

2020-04-02 11:38:50

propose: 12pm?

wenyi

2020-04-02 11:55:18

5 分鐘後嗎

chihao

2020-04-02 11:55:39

好像需要 @ronnywang 😛

pm5

11:38:15

yeah

chihao

11:38:50

propose: 12pm?

wenyi

11:55:18

5 分鐘後嗎

chihao

11:55:39

好像需要 @ronnywang 😛

chihao

12:00:10

ronnywang

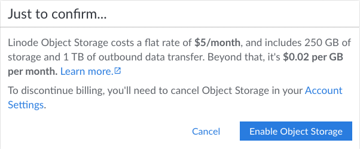

13:01:05

Linode Guides & Tutorials

Object Storage pricing breakdown, storage limits, transfer quotas, and other pertinent information.

ronnywang

13:59:46

Object storage 好了,相關 key 和使用方法丟給 @pm5 了

chihao

13:59:52

\o/

chihao

14:00:01

@ronnywang ++

ronnywang

20:43:29

現在空間 87% 了

chihao

20:59:32

怎麼⋯

pm5

22:43:52

到 90% 的話就先關掉 scraper 等我們弄好吧?

pm5

22:44:36

202002 快要 dump 好了

mglee

23:19:55

也許大家早就知道這個了:The Hamilton 2.0 dashboard 專門在收集中國與俄國在網路上的政治宣傳,他們資料呈現的方式可以參考

https://securingdemocracy.gmfus.org/hamilton-dashboard/

https://securingdemocracy.gmfus.org/hamilton-dashboard/

Alliance For Securing Democracy

The Hamilton 2.0 dashboard, a project of the Alliance for Securing Democracy at the German Marshall Fund of the United States, provides a summary analysis of the narratives and topics promoted by Russian and Chinese government officials and state-funded media on Twitter, YouTube, state-sponsored news websites, and via official diplomatic statements at

- 👍2

2020-04-03

chihao

10:13:08

正在寫第二次的 System Report。從上一次報告到這一次,資料分析和 community 的部分似乎沒有什麼新的發展 orz (my bad)

chihao

10:29:28

@mglee 也許能夠有什麼合作呢 🤔

chihao

10:30:07

Hamilton 2.0 Dashboard 專案 funder 是 GMF - German Marshall Fund

chihao

10:30:45

Just thinking out loud here 😛

ronnywang

22:01:04

89% 了

ronnywang

23:13:10

暫時解除硬碟空間警報 XD

ronnywang

23:14:46

@pm5 如果用 「s3cmd put --acl-public [somefile] <s3://0archive/>」,可以把這個檔案上傳到 object storage 並且會有一個可下載的網址e

ronnywang

23:15:04

如果東西是想要 open 並有下載網址的話,可以加上 --acl-public

2020-04-04

2020-04-05

ael

12:15:37

4/7 有個線上討論分析 Twitter 上機器人帳號的演講,我不知道分享在這裡適不適合

https://cyber.harvard.edu/events/virtual-event-bot-or-human-unreliable-automatic-bot-detection

https://cyber.harvard.edu/events/virtual-event-bot-or-human-unreliable-automatic-bot-detection

Berkman Klein Center

Jonas Kaiser and Adrian Rauchfleisch discuss their paper on Botometer's diagnostic ability over time

pm5

15:47:39

昨天(4/4)又遇到 discover 與 update processes 不明原因掛掉因此 PID table 沒有清掉所以一整天沒有跑 discover & update 的問題

- 😢1

2020-04-06

chihao

20:05:08

要不要換 jitsi

pm5

20:05:12

我什麼都聽不到耶

pm5

20:05:14

好

wenyi

20:06:22

jitsi: This site can’t be reached 欸

pm5

20:06:33

chihao

20:06:35

whaaaa

pm5

20:06:39

打錯了

chihao

20:06:47

chihao

20:07:58

快打敗 Zoom 吧 QQ

ronnywang

20:08:39

zoom 是不是沒有網頁版,一定要下載應用程式?

chihao

20:08:56

才可以偷你的資料給中國(NO)

2020-04-08

pm5

10:22:30

真新聞關站了?

ronnywang

10:33:09

Matters

作者:丁新一前情提要見〈或許,耿爽沒那麼不爽——我們要「製造假新聞」來回擊中國的資訊戰嗎?〉、〈台灣研發快篩,中國在WHO收割……嗎?〉「公民廟口」粉專已於今日取消發佈(僅限在粉絲專頁有角色的用戶可見,一般用戶不可見),...

- 🖖1

pm5

10:34:24

https://fongnews.net/ 這裡面的文章網址不太確定應該怎麼抓

溏風報

「溏風報新聞傳媒」即時、公正、深入觀點,從即時新聞、社群輿論、主題節目影音、即時線上直播、社會論點、名家觀點、生活娛樂,讓讀者快速掌握完整的新聞時事。

另一方面,它有 RSS https://fongnews.net/feed

wenyi

2020-04-11 01:12:17

我加了~

`^comment|tag|category).)*/$` 測試了一下應該ok

`^comment|tag|category).)*/$` 測試了一下應該ok

Shiva

12:40:39

@shivaxsin has joined the channel

KenChen

12:41:29

@a7164265 has joined the channel

tnstiger

16:08:35

@chihao @a7164265 是我要介紹給你的小夥伴

2020-04-09

pm5

09:29:25

備份程式 dump 每天出來的 snapshot 資料總是比 site states 算出來的筆數多一些 🤔

- 🤔1

wenyi

2020-04-09 11:34:18

是比discover + update stats多嗎?大概多多少啊?

wenyi

2020-04-09 12:00:35

哦⋯看起來是 stats 算update數有bug,會漏掉在day 1 計算 day 0 stats前又再次update的articles... 我明天修一下更新stats table

wenyi

2020-04-10 07:11:50

@pm5 每天dump的哪些snapshot是怎麼決定的啊?我更新了stats算法,discover+update 數跟每日snapshot count是一樣的, 但跟每天dump出來的row數還是有差

例如2020-04-03有 `90326` snapshots, from sql:

```select count(*) from ArticleSnapshot

where date(snapshot_at_date)="2020-04-03"

--> get 90326```

2020-04-03的dump看googlesheet row_count 是 `90,704`。

--備註新的stats 算法:

discover:

https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_discovered_in_interval.sql

update: https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_updated_in_interval.sql

例如2020-04-03有 `90326` snapshots, from sql:

```select count(*) from ArticleSnapshot

where date(snapshot_at_date)="2020-04-03"

--> get 90326```

2020-04-03的dump看googlesheet row_count 是 `90,704`。

--備註新的stats 算法:

discover:

https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_discovered_in_interval.sql

update: https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_updated_in_interval.sql

dump 的計算方式是 `snapshot_at` >= 當天 00:00:00、< 隔天 00:00:00

下的指令類似是 `ns-dump -r 1d:2020-04-03` https://github.com/disinfoRG/ZeroScraper/blob/master/scripts/upload-snapshots.sh

wenyi

2020-04-10 23:43:54

嗯…看了一下 `ns-dump` 的date_range 還有queries `get_snapshot_in_keys_date_ranged` , 2020-04-03的snapshot 數的確應該是跟stats吻合的 `90326` 筆,不太知道多出來的是從哪裡來的…

```select count(*) from ArticleSnapshot

where snapshot_at >= 1585843200 and snapshot_at<1585929600;```

```select count(*) from ArticleSnapshot

where snapshot_at >= 1585843200 and snapshot_at<1585929600;```

pm5

09:30:40

想了一下,會不會像鄉民看電視一樣存截圖也可以?

chihao

10:20:36

._.

chihao

10:22:12

@ayw255 YtScraper 關於 Update 的邏輯寫在 README 裡,不知道是不是跟 ZeroScraper 一致?

GitHub

Contribute to chihaoyo/YtScraper development by creating an account on GitHub.

wenyi

2020-04-09 11:18:14

是~除了ZeroScraper的兩個月是距離first_snapshot_at的兩個月 (60天),因為沒有parse之前不知道published_at。

chihao

10:22:24

@a7164265 哈囉哈囉 👋

wenyi

11:34:18

是比discover + update stats多嗎?大概多多少啊?

wenyi

12:00:35

Replied to a thread: 2020-04-09 09:29:25

哦⋯看起來是 stats 算update數有bug,會漏掉在day 1 計算 day 0 stats前又再次update的articles... 我明天修一下更新stats table

pm5

12:37:50

不知道為什麼,密訊的網站特別對 Facebook 與 Dcard 有調整,soure code 看起來可能是顯示個 info box 還是什麼的。在 HTML 裡搜尋 `dcardsource` 就會看到

2020-04-10

wenyi

07:11:50

@pm5 每天dump的哪些snapshot是怎麼決定的啊?我更新了stats算法,discover+update 數跟每日snapshot count是一樣的, 但跟每天dump出來的row數還是有差

例如2020-04-03有 `90326` snapshots, from sql:

```select count(*) from ArticleSnapshot

where date(snapshot_at_date)="2020-04-03"

--> get 90326```

2020-04-03的dump看googlesheet row_count 是 `90,704`。

--備註新的stats 算法:

discover:

https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_discovered_in_interval.sql

update: https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_updated_in_interval.sql

例如2020-04-03有 `90326` snapshots, from sql:

```select count(*) from ArticleSnapshot

where date(snapshot_at_date)="2020-04-03"

--> get 90326```

2020-04-03的dump看googlesheet row_count 是 `90,704`。

--備註新的stats 算法:

discover:

https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_discovered_in_interval.sql

update: https://github.com/disinfoRG/ZeroScraper/blob/master/queries/count_articles_updated_in_interval.sql

pm5

19:55:11

dump 的計算方式是 `snapshot_at` >= 當天 00:00:00、< 隔天 00:00:00

pm5

19:55:13

GitHub

Web scraper made by 0archive. Contribute to disinfoRG/ZeroScraper development by creating an account on GitHub.

pm5

19:56:23

下的指令類似是 `ns-dump -r 1d:2020-04-03` https://github.com/disinfoRG/ZeroScraper/blob/master/scripts/upload-snapshots.sh

GitHub

Web scraper made by 0archive. Contribute to disinfoRG/ZeroScraper development by creating an account on GitHub.

wenyi

23:43:54

嗯…看了一下 `ns-dump` 的date_range 還有queries `get_snapshot_in_keys_date_ranged` , 2020-04-03的snapshot 數的確應該是跟stats吻合的 `90326` 筆,不太知道多出來的是從哪裡來的…

```select count(*) from ArticleSnapshot

where snapshot_at >= 1585843200 and snapshot_at<1585929600;```

```select count(*) from ArticleSnapshot

where snapshot_at >= 1585843200 and snapshot_at<1585929600;```

2020-04-11

wenyi

01:12:17

Replied to a thread: 2020-04-08 10:34:24

我加了~

`^comment|tag|category).)*/$` 測試了一下應該ok

`^comment|tag|category).)*/$` 測試了一下應該ok

- 😆1

chihao

20:57:07

中天新聞CH52 https://www.youtube.com/channel/UCpu3bemTQwAU8PqM4kJdoEQ/

中天電視 https://www.youtube.com/channel/UC5l1Yto5oOIgRXlI4p4VKbw

這兩個有什麼差別 / 關聯? @ronnywang 😛

中天電視 https://www.youtube.com/channel/UC5l1Yto5oOIgRXlI4p4VKbw

這兩個有什麼差別 / 關聯? @ronnywang 😛

YouTube

「未經著作權人事先書面同意,勿將內容用於商業性質之分享、連結。」 ►►►歡迎訂閱【中天電視】YouTube頻道家族◄◄◄ 我愛小明星大跟班:<https://www.youtube.com/channel/UCCiV0FmfqgLRC9zYjj1Q4IA> 麻辣天后傳:<https://www.youtube.com/>...

ronnywang

20:57:26

中天電視還有別的節目

ronnywang

20:57:29

兩個是不同頻道

ronnywang

20:57:50

中天電視是綜合頻道,新聞是 24hr 新聞台

chihao

20:58:09

鄉民看電視是關心前者嗎?

chihao

20:59:04

哦~中天電視還有這個連結 https://www.youtube.com/user/ctitv/ 是個 user

YouTube

「未經著作權人事先書面同意,勿將內容用於商業性質之分享、連結。」 ►►►歡迎訂閱【中天電視】YouTube頻道家族◄◄◄ 我愛小明星大跟班:<https://www.youtube.com/channel/UCCiV0FmfqgLRC9zYjj1Q4IA> 麻辣天后傳:<https://www.youtube.com/>...

chihao

20:59:38

但 YouTube API 看來似乎把 channel 和 user 當成同一個等級的東西?

2020-04-12

delightfullychaotic

21:56:33

@delightfullychaotic has joined the channel

2020-04-15

pm5

09:21:38

之前 @ayw255 說有些錯誤新聞出現在線上媒體的時候我們沒有抓到,只抓到後來的澄清文,不知道現在漏抓新聞情況有沒有改善。我後來想想也可以把 discover 的頻率改成半小時或更短時間一次試試看

對八卦板也許也有用

wenyi

2020-04-16 00:14:48

上次想說的其實是,錯誤新聞看起來多數出現在Line、微信聊天室這些不在我們觀察的目標中,本來好像就不太常出現在線上媒體的說QQ。

這是事實查核中心的list,其中有出現在媒體的只有少少幾則,最著名的大概是鍾南山說蓮蓬頭會傳染肺炎、還有從空氣檢測推測武漢燒很多屍體

我們關注的內容網站有很多莫名的文章,但就不是現在會引起關注的假新聞(沒有成功傳播 LOL?)

https://tfc-taiwan.org.tw/articles/2366

這是事實查核中心的list,其中有出現在媒體的只有少少幾則,最著名的大概是鍾南山說蓮蓬頭會傳染肺炎、還有從空氣檢測推測武漢燒很多屍體

我們關注的內容網站有很多莫名的文章,但就不是現在會引起關注的假新聞(沒有成功傳播 LOL?)

https://tfc-taiwan.org.tw/articles/2366

聊天群組裡流傳的資訊,可能就要靠跟別的專案合作來共享資料了⋯⋯0archive data standard 的目的也是希望讓這種資料流通更容易一點

pm5

09:22:07

對八卦板也許也有用

2020-04-16

wenyi

00:14:48

上次想說的其實是,錯誤新聞看起來多數出現在Line、微信聊天室這些不在我們觀察的目標中,本來好像就不太常出現在線上媒體的說QQ。

這是事實查核中心的list,其中有出現在媒體的只有少少幾則,最著名的大概是鍾南山說蓮蓬頭會傳染肺炎、還有從空氣檢測推測武漢燒很多屍體

我們關注的內容網站有很多莫名的文章,但就不是現在會引起關注的假新聞(沒有成功傳播 LOL?)

https://tfc-taiwan.org.tw/articles/2366

這是事實查核中心的list,其中有出現在媒體的只有少少幾則,最著名的大概是鍾南山說蓮蓬頭會傳染肺炎、還有從空氣檢測推測武漢燒很多屍體

我們關注的內容網站有很多莫名的文章,但就不是現在會引起關注的假新聞(沒有成功傳播 LOL?)

https://tfc-taiwan.org.tw/articles/2366

WaterMai

12:29:42

@akasukilee has joined the channel

2020-04-17

chihao

10:21:42

https://ocf.tw/p/pttid/ ocf \o/

ocf.tw

網路上的不實資訊、網軍操作帶風向的狀況層出不窮,批踢踢實業坊 (PTT) 的政治類看板, 比起其他看板,帶風向的情形更加嚴重,網路上已經有很多專家利用爬蟲工具,自行搜尋分析出活動異常的 PPT 使用者帳號。本計畫希望能網羅各方資源之外,也能開發出套完整的開源工具,讓使用者自行析判斷誰是誰非。

- 👍5

3

3

pm5

10:43:13

聊天群組裡流傳的資訊,可能就要靠跟別的專案合作來共享資料了⋯⋯0archive data standard 的目的也是希望讓這種資料流通更容易一點

chihao

22:26:36

@pm5 不知道能不能請求更新 disinfoRG/datasets 部分內文公開資料集 😆

2020-04-18

chihao

00:43:12

謝謝 pm5 \o/

pm5

22:03:10

我想來把 datasets 釋出的資料 id 改成 uuid https://github.com/disinfoRG/ArticleParser/pull/26

I think we should switch producer and publication id to UUID for a few reasons: • Some benefits of UUID in general: • It is not sequential so it does not reveal that much information about orders. • It can be generate in the program so if we are going to have multiple parsers running on multiple databases it is not that hard to merge the data into a single dataset. • We cannot use article id for publications and site id for producers anyway, now that we are going to get scraped data from multiple upstream scrapers.

2020-04-19

ish

16:13:20

@sandy051122 has joined the channel

2020-04-20

chihao

21:06:08

Jitsi 怎麼了

wenyi

21:07:18

我們還在meeting耶,你無法加入嗎

chihao

21:07:20

也許是我的問題,斷線之後就連不進去了 orz

wenyi

21:07:24

orz

chihao

21:08:12

orz orz orz

wenyi

21:09:03

你現在加入了嗎

chihao

21:09:07

有看到我在裡面嗎?

wenyi

21:09:08

有看到你的頭像

wenyi

21:09:09

有

chihao

21:09:14

但沒聲音

chihao

21:09:19

我看到你們都是靜音

chihao

21:10:41

進不去 orz

chihao

21:11:02

Can we try Google Meet? https://meet.google.com/gmn-tqtd-pdx @pm5 @ayw255 sorry

meet.google.com

Real-time meetings by Google. Using your browser, share your video, desktop, and presentations with teammates and customers.

pellaeon

23:36:27

@pellaeon has joined the channel

2020-04-21

Oliver Chang

07:55:07

@iche.chang has joined the channel

pm5

21:19:20

@ronnywang 你上次 disinfo 小松,用 elasticsearch 做的相似文章的分析,那時候用的中文 analyzer 是 smartcn 嗎?

ronnywang

21:20:05

好像只有用 cjk

ronnywang

21:20:19

```{

"text": {

"properties": {

"id" : { "type": "string", "null_value": "na", "index": "not_analyzed"},

"text" : { "type": "string", "null_value" : "na", "index" : "analyzed", "analyzer" : "cjk"}

}

}

}```

"text": {

"properties": {

"id" : { "type": "string", "null_value": "na", "index": "not_analyzed"},

"text" : { "type": "string", "null_value" : "na", "index" : "analyzed", "analyzer" : "cjk"}

}

}

}```

- 🖖2

ronnywang

21:20:23

當時的設定檔

chihao

21:55:48

2020-04-22

2020-04-23

chihao

09:45:39

收到 `not okay` 了 😱

- 😮1

wenyi

2020-04-23 23:18:37

哎呀又是之前那個Variable沒有清掉的狀況。剛剛清掉了下一支應該會正常跑

fly

15:17:23

*CUP

傳統上,國家、政府和某些國際組織把持著調查案件的權力和資源,面對涉及政權的衝突、懸疑未解的國際爭議,升斗市民是否就無計可施,只能被動地等結論?在網絡發達、資訊唾手可得的今天,Bellingcat 告訴世人:只要適當運用科技、智慧、觀察力和耐性,人人都可以為捍衛真相出一分力。

wenyi

23:18:37

哎呀又是之前那個Variable沒有清掉的狀況。剛剛清掉了下一支應該會正常跑

2020-04-27

chihao

21:43:41

@a-chioh 0archive 5/16(週六)想在線上辦小松,有空嗎?要不要一起來玩資料?😄

pm5

22:28:17

yo @nondayo 👆

chihao

22:44:01

如果是 5/16 週六 10am-1pm && 2pm-5pm 這兩個時段大家覺得如何?都可以嗎?想要有早上的時段這樣美東的團隊成員才可以參加 😄

chihao

22:55:24

HackMD

# 0archive 零時檔案局 :closed_book: ## 想跳坑嗎 - [跳坑指南 Intro](/cdctnMJWQpKWQYhSxB8sCw) - [行事曆 Calendar](<https://docs>.

chihao

22:55:41

@ronnywang 5/16 小松來嗎?😆

2020-04-28

tkirby

01:47:54

喔喔! 可能要到時候看一下家裡的狀況