Hugging Face dataset page:

https://huggingface.co/datasets/Cofacts/line-msg-fact-check-tw

Example Colab (含有如何 join table 做一個 classifier 需要的 train data)

https://colab.research.google.com/drive/1qdE-OMJTi6ZO68J6KdzGdxNdheW4ct6T

自由時報電子報

唐鳳:AI將對中國極權帶來挑戰 - 政治 - 自由時報電子報

數位部長唐鳳廿二日出席華盛頓「全球新興科技高峰會」(SCSP)並發表談話,稱台灣在對抗擁有數倍人力物力資源的中國資安、假訊息攻勢時,可藉由生成式人工智慧(AI)協助彌補人力上的差距。唐鳳接受「美國之音」專訪時分析,言論審查既會對中國的AI應用、發展形成障礙,AI也會對中國的極權政體帶來極大挑戰。唐鳳向美國之音表示,台灣在資安聯防方面持續與美國合作,此次訪美聚焦的新威脅之一為生成式AI。除了與美官員討論,更重要的是把台灣的顧慮和美方的關切、想法彙整後,提供給Meta、Google、Open AI、Anthropic等尖端AI研究公司。

徵求「交大資工服務學習課程自由軟體組」的參與專案 大家好,我跟軟自協的 <@U1GJ4AK2T>、前教育部自由軟體中心的 Eric Sun 及維基社群的 <@U1D5ZHDCN> 每學期都會去交大資工協助服務學習自由軟體組。由於今年系上想要擴大舉辦,因此想要徵求一些有興趣帶領大一同學:beginner::beginner::beginner:的坑主來加入。 有興趣提供貢獻機會,請把專案資料填寫到此份投影片:<https://docs.google.com/presentation/d/1ZnbJy5_qpjOYPtkoH88v3X8IGVQ6yNVEloRipg_MVzc/edit?usp=sharing> (參與項目不限寫 code) 我們將會在 10/13 去學校舉辦說明會,到時會將投影片提供給同學參考,我也會快速介紹一輪。會後供他們自由選擇有興趣的項目,再直接按照投影片上的資訊聯絡各專案坑主。 (另外,系上也希望額外邀請參與者來系上演講,分享自己的開源及程式貢獻社會的經驗等(此項有演講費)。時間可安排在十一月或十二月下午或晚上,有興趣也請舉手一下。)

徵求「交大資工服務學習課程自由軟體組」的參與專案 大家好,我跟軟自協的 <@U1GJ4AK2T>、前教育部自由軟體中心的 Eric Sun 及維基社群的 <@U1D5ZHDCN> 每學期都會去交大資工協助服務學習自由軟體組。由於今年系上想要擴大舉辦,因此想要徵求一些有興趣帶領大一同學:beginner::beginner::beginner:的坑主來加入。 有興趣提供貢獻機會,請把專案資料填寫到此份投影片:<https://docs.google.com/presentation/d/1ZnbJy5_qpjOYPtkoH88v3X8IGVQ6yNVEloRipg_MVzc/edit?usp=sharing> (參與項目不限寫 code) 我們將會在 10/13 去學校舉辦說明會,到時會將投影片提供給同學參考,我也會快速介紹一輪。會後供他們自由選擇有興趣的項目,再直接按照投影片上的資訊聯絡各專案坑主。 (另外,系上也希望額外邀請參與者來系上演講,分享自己的開源及程式貢獻社會的經驗等(此項有演講費)。時間可安排在十一月或十二月下午或晚上,有興趣也請舉手一下。)

HackMD

Cofacts reasearch & design docs - HackMD

# Cofacts reasearch & design docs :::info - Design docs: Implementation documents with requiremen

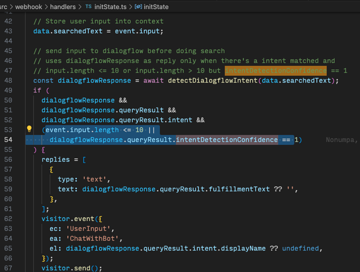

#327 Cannot record feedback in certain state

From <https://g0v.hackmd.io/IqCOZMZLRe-JPMSJIV3yRQ#Feedback-%E7%84%A1%E6%B3%95%E7%B4%80%E9%8C%84|20220921 meeting> *Steps to reproduce* 1. 給一圖,觸發兩則圖 A, B 2. 先選一個有多個回應的圖 A,但不選回應 3. 捲回去選單一回應的圖 B,觸發回應 4. 捲回去挑一個 A 的回應顯示 5. 對該回應按「有用」或「沒用」 6. 按關閉,會出現「無法紀錄您的評價」 <https://user-images.githubusercontent.com/108608/191897488-87dae2c5-2531-4c8a-a8b0-d01a5aba7b71.png|image> <https://user-images.githubusercontent.com/108608/191897504-9496c8a1-bc17-4e64-b861-61e4c2098d89.png|image> <https://user-images.githubusercontent.com/108608/191897512-7783dac7-cf69-4b17-bcd1-5005984e5c40.png|image>

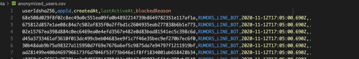

#27 feat(dumpOpenData): add fields for CIB prediction

• Add block/normal status for entities with status • Add article type • Add anonymized user

g0v.hackmd.io

OCR and AI transcripts - HackMD

HackMD

# Cofacts 會議記錄 - [搜尋](<https://cse.google.com/cse?cx=71f4f7ee215d54fe6>)[target=_blank] ## 2023 -

developers.line.biz

The LINE Developers site is a portal site for developers. It contains documents and tools that will help you use our various developer products. Creating LINE Login and Messaging API applications and services has never been easier!

line.me

g0v.hackmd.io

ndltd.ncl.edu.tw

利用深度學習方法和「Cofacts真的假的」資料進行Covid-19真假訊息的分類__臺灣博碩士論文知識加值系統

身處在網路、電腦硬體設備發達之資訊社會,新聞的生產與需求都快速擴張之際,假新聞憑藉著傳播載具之進化,築基在新聞自由上之故意散佈虛假資訊行為,引發本研究之動機。 而Covid-19假訊息之影響範圍遍及全臺灣及全世界,對閱聽眾帶來來之不良影響深遠無邊,故本研究目的為:「利用深度學習方法結合〈Cofacts真的假的〉資料進行真假訊息的分類。」 本研究以〈Cofacts 真的假的〉作為資料搜集平台,僅搜集「含有正確訊息」與「含有錯誤訊息」之文字格式,並聚焦在以Covid-19為主題之繁體中文做為本研究資料集。實驗一以BERT模型進行分類,為降低模型輸出之隨機性,故執行五次訓練並取平均值, Accuracy平均為0.9043;實驗二以大型語言模型LLM架構下之生成式語言模型ChatGLM-6B進行分類任務,Accuracy達0.8996;在字數超過512字以上之長文本分類表現 Accuracy達0.9230。 藉由實驗證明,在深度學習模型中,無論其初始設計目標是針對分類任務或生成任務,皆不會使模型在分類任務上有明顯鑑別,面對假訊息之有關機關應可彈性應用BERT、ChatGLM-6B兩者工具,避免Covid-19假訊息侵擾社會造成公眾危害。 在硬體設備允許之情況下,若有假新聞以外之長文本分類需求時,亦可選用參數量龐大之LLM大型語言模型來進行分類任務。

MyGoPen

【錯誤】烏軍亞速營殺害平民嫁禍俄羅斯影片?實為2013年敘利亞屠殺事件

網傳「烏軍“亞速營“殺害平民嫁禍 俄羅斯」的影片與訊息。經查證,影片實為 2013 年敘利亞 Tadamon 大屠殺事件的畫面,近期才被揭露,由《衛報》(The Guardian)中東記者 Martin Chulov 報導,和烏克蘭及亞速營均無關。「烏軍亞速營殺害平民築萬人坑。嫁禍是俄軍做的」、「人

g0v.hackmd.io

tsjournal.org

Journal of Online Trust and Safety

tsjournal.org

Journal of Online Trust and Safety

google.com

Workis Studio · No. 7號, Lane 184, Section 2, Jilong Rd, Da’an District, Taipei City, Taiwan 106

★★★★★ · Coworking space

幫 <@U2X3JLRT9> 來推廣一下他們在美國國會台灣觀測站黑克松和昨天 <#C05FZAX1Z9U|g0v-siliconvalley> 的提案,看看這邊有沒有人有興趣一起合作 2023 US Taiwan Watch Hackathon - 認知症疫苗 <https://docs.google.com/presentation/d/1rd0LCe3bn24OqS_5pmKF5p2BWpM8d1i2LpesNBFFRiI/edit#slide=id.p> 大眾對假消息敏感度/辨識度不高 => 社群小遊戲:這是假消息嗎? <https://is-this-fake-news.vercel.app/|試玩連結>

幫 <@U2X3JLRT9> 來推廣一下他們在美國國會台灣觀測站黑克松和昨天 <#C05FZAX1Z9U|g0v-siliconvalley> 的提案,看看這邊有沒有人有興趣一起合作 2023 US Taiwan Watch Hackathon - 認知症疫苗 <https://docs.google.com/presentation/d/1rd0LCe3bn24OqS_5pmKF5p2BWpM8d1i2LpesNBFFRiI/edit#slide=id.p> 大眾對假消息敏感度/辨識度不高 => 社群小遊戲:這是假消息嗎? <https://is-this-fake-news.vercel.app/|試玩連結>

HackMD

# Cofacts 會議記錄 - [搜尋](<https://cse.google.com/cse?cx=71f4f7ee215d54fe6>)[target=_blank] ## 2023 -

3 new ways to check images and sources online

Today, we’re announcing three new ways that you can get more context about the images and sources you’re finding online.

nextjs.org

Next.js 14 includes included performance, stability for Server Actions, a new course teaching the App Router, and more.